Dans le monde du SEO et de la création web en général, c’est un terme dont on entend presque tout le temps parler. Ah, les fameux Core Web Vitals… Le genre de truc toujours à la mode depuis leur sortie…

Si je vous demande de me définir ce qu’est un fichier robots.txt sur WordPress, êtes-vous capable de me donner une réponse du tac au tac ?

Pas facile, n’est-ce pas ? D’ailleurs, sans le savoir, vous en avez déjà sûrement un sur votre site.

Le truc, c’est qu’on n’y comprend pas toujours grand-chose, à ce fameux fichier. À quoi sert-il ? Qu’est-ce qu’on met dedans ? Pourquoi son code ressemble à du chinois ?

Si vous vous êtes déjà renseigné sur le sujet, je parie que vous vous êtes posé ces questions.

Un peu comme la dynamite, ce fichier doit être manipulé avec beaucoup de précaution.

Si vous le configurez mal, vous risquez de plomber le référencement de votre site. Alors, gare à l’explosion !

Dans cet article, je vais vous montrer comment éviter la catastrophe, et comment optimiser votre fichier robots.txt. Vous découvrirez notamment à quoi il sert, son mode de fonctionnement, deux façons de le créer, et ce qu’il faut mettre à l’intérieur.

Sommaire

Initialement rédigé en août 2018, cet article a été mis à jour en janvier 2022.

Qu’est-ce que le fichier robots.txt ?

Présentation

Un fichier robots.txt est un fichier texte situé à la racine de votre site qui « indique aux robots d’exploration d’un moteur de recherche les URL auxquelles il peut accéder sur votre site », selon la définition donnée par Google sur son site d’aide aux webmasters.

Aussi désigné sous le nom de « Protocole d’exclusion des robots », il permet d’éviter l’indexation par les moteurs de recherche de certains contenus inutiles et/ou privés (ex : votre page de connexion, des dossiers et fichiers sensibles).

En résumé, ce protocole indique aux robots d’un moteur de recherche ce qu’ils peuvent faire ou non sur votre site.

Voici comment cela fonctionne. Lorsqu’un robot est sur le point de crawler une URL de votre site (c’est-à-dire qu’il va explorer et récupérer des informations pour pouvoir ensuite les indexer), il va d’abord chercher à consulter votre fichier robots.txt.

S’il le trouve, il va le lire, puis suivre les directives que vous aurez renseignées (il ne pourra pas explorer tel ou tel fichier si vous lui avez interdit).

S’il ne le trouve pas, il explorera votre site de façon normale, sans exclure aucun contenu.

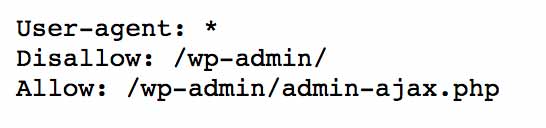

J’ai saisi la bête dans son plus simple appareil. Regardez cet exemple de fichier robots.txt sur WordPress pour voir à quoi cela ressemble :

Ne vous arrêtez pas forcément sur son contenu. Vous le verrez plus tard, il n’existe pas de fichier-type adaptable sur n’importe quel site. En tout cas, cela n’est pas conseillé.

Si vous deviez retenir 4 choses supplémentaires sur notre sujet du jour, mettez-vous ça dans le crâne :

- Comme l’explique Google, les indications que vous donnez dans votre fichier

robots.txt« ne peuvent pas obliger le robot d’exploration à respecter les règles de votre site ». Si les robots d’exploration « sérieux » (Google, Bing, Yahoo, Yandex, Baidu etc.) vont les respecter, ce ne sera pas le cas des robots malveillants, qui cherchent à mettre à mal la sécurité de votre site.

De plus, tous les robots n’interprètent pas les instructions de la même façon, veillez donc à bien respecter la syntaxe indiquée par Google. - Le fichier

robots.txtest un fichier public. N’importe qui peut y accéder en tapant le modèle suivant :votresite.fr/robots.txt. Par conséquent, ne vous en servez pas pour cacher du contenu, on trouvera vite où il est planqué… Si vous voulez que du contenu reste privé, ne l’insérez pas dans ce fichier, mais protégez-le par mot de passe par exemple. - Si vous souhaitez que certaines pages n’apparaissent pas dans les résultats de recherche, « n’utilisez pas le fichier

robots.txtpour masquer votre page Web », détaille Google. En effet, si un certain nombre de liens pointent vers cette page, il est possible que Google l’indexe et l’affiche dans ses résultats de recherche, sans savoir ce qu’elle contient, même si vous l’avez bloquée dans votre fichierrobots.txt.

Pour empêcher une page d’apparaître dans les résultats de recherche, Google préconise d’utiliser ce que l’on appelle une balisenoindex(on peut l’activer facilement dans Yoast SEO en décochant la case « Autoriser les moteurs de recherche à afficher le contenu XXX dans les résultats de recherche ? » située sous chaque article/page au niveau de l’onglet des réglages). - Le fichier

robots.txta un cousin prénommé humans.txt.

Il s’agit d’un fichier TXT, également situé à la racine de votre site, qui contient des informations sur les différentes personnes qui ont contribué à sa conception.

Par exemple, les développeurs, webdesigners, rédacteurs etc. Il n’a rien d’obligatoire, mais si vous jugez utile de l’intégrer sur votre WordPress, il faudra l’ajouter à la racine de votre site, à côté du fichierrobots.txt(regardez celui de WPMarmite par exemple).

Avez-vous vraiment besoin d’un fichier robots.txt ?

Par défaut, un site web sera exploré et indexé normalement par un moteur de recherche, même sans la présence d’un fichier robots.txt.

Ce dernier n’a donc rien d’obligatoire. Comme l’explique Daniel Roch, spécialiste du référencement WordPress, « si vous avez dans l’optique de référencer l’intégralité de vos pages, de vos contenus et de vos médias, n’utilisez pas le fichier robots.txt : il ne vous servira à rien ».

Mais alors, quelle peut être l’utilité de ce fichier, le reste du temps ?

Le bénéfice principal est à chercher du côté de votre référencement naturel (SEO). En fait, un fichier robots.txt permet d’économiser ce que l’on appelle le budget de crawl (ou budget d’exploration), indique cet article (en anglais) du blog de Yoast SEO.

C’est assez technique, mais pour faire simple, en désindexant les pages de votre site ne présentant aucun intérêt SEO, vous laisserez plus de temps et d’énergie à Google pour explorer les autres.

Si vous souhaitez creuser le sujet, Olivier Duffez, du site WebRank Info, en parle par ici.

Désormais, il est temps de passer à la configuration de votre fichier. Et c’est important, croyez-moi. S’il n’est pas correctement optimisé, vous risquez de sérieusement pénaliser votre présence sur les moteurs de recherche.

Comment créer un fichier robots.txt sur WordPress ?

Par défaut, WordPress crée un fichier robots.txt virtuel. Il n’est pas accessible sur votre serveur, mais vous pouvez le consulter en ligne.

Prenons celui du site d’Usain Bolt, l’ex-star jamaïcaine du sprint.

Pour le voir, il vous suffit de taper dans votre navigateur : http://usainbolt.com/robots.txt.

Voici ce que vous obtiendrez :

Ce fichier virtuel fonctionne. Mais comment faire pour modifier ce robots.txt sur votre site WordPress ?

Eh bien vous allez devoir créer votre propre fichier pour le remplacer.

Pour cela, il y a deux façons de procéder :

- utiliser un plugin ;

- le créer manuellement.

Je vous propose de découvrir cela en détails.

La méthode pour créer un fichier robots.txt sur WordPress avec Yoast SEO

Je suis prêt à parier que vous connaissez Yoast SEO, non ? Vous savez, il s’agit d’un plugin de référencement, l’un des plus téléchargés de tous les temps.

WPMarmite l’utilise, et je vais aussi m’en servir pour vous montrer comment il peut vous permettre de créer un fichier robots.txt.

Évidemment, le préalable est que vous ayez installé, puis activé cette extension.

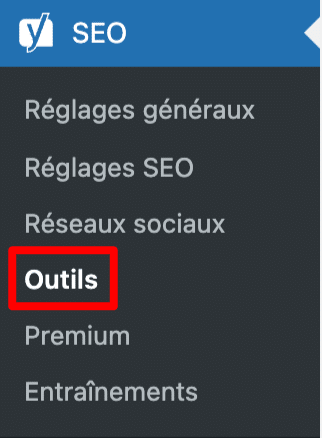

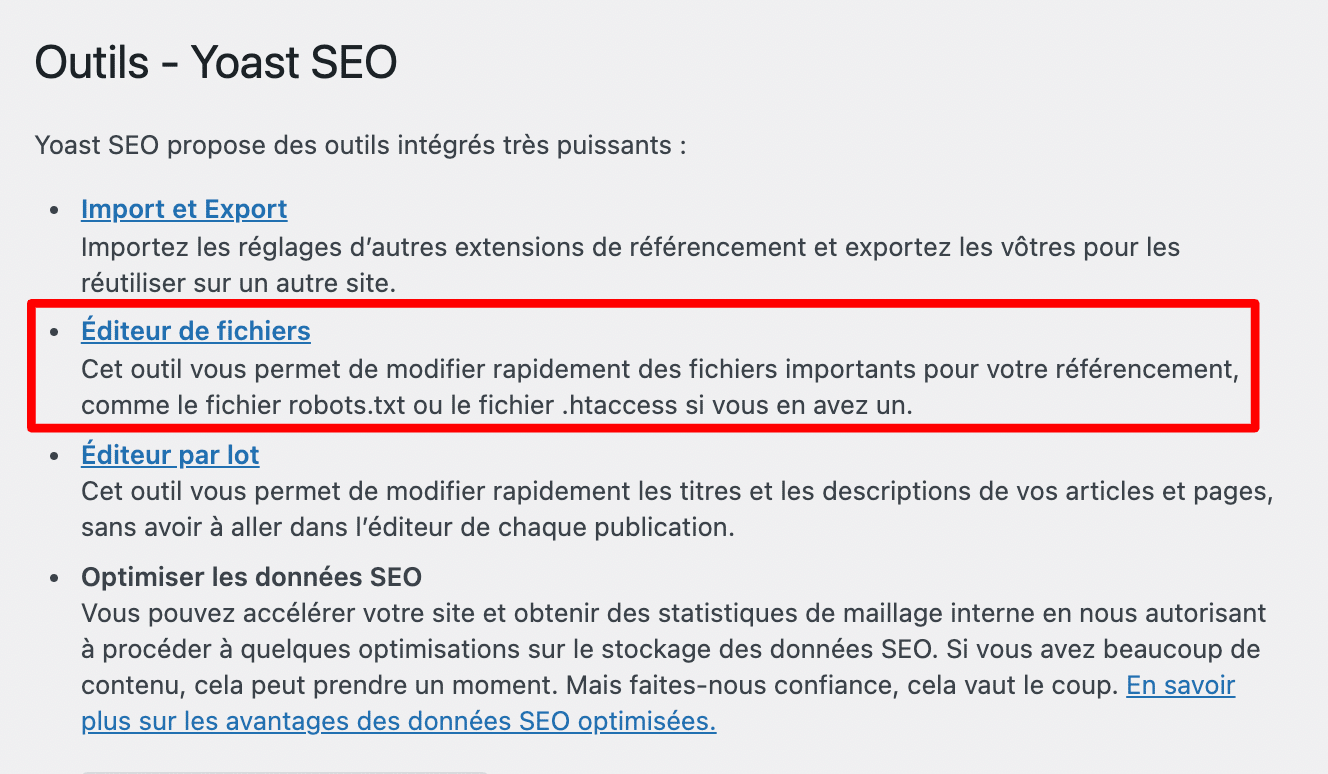

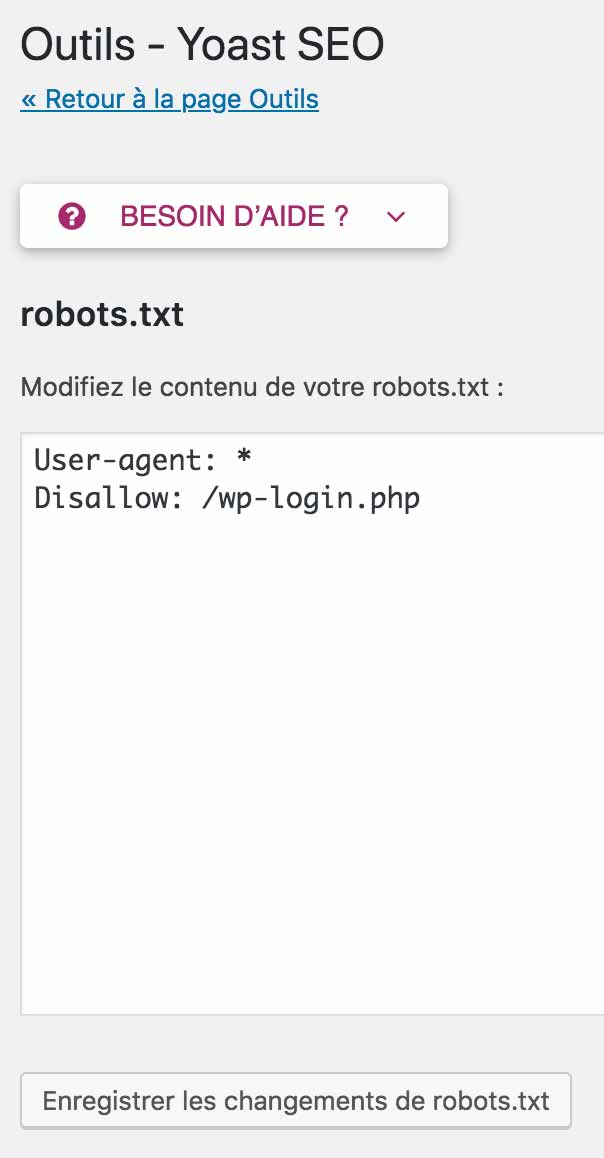

Commencez par vous rendre sur votre Tableau de bord WordPress, et sélectionnez Yoast SEO > Outils.

Poursuivez en cliquant sur « Éditeur de fichiers ».

Si vous n’avez pas encore de fichier dédié, cliquez sur le bouton pour en créer un. Pour ma part, j’en avais déjà un sur mon site, donc je ne pouvais que le modifier. Et pensez à bien enregistrer, une fois que vous avez terminé.

Et voilà, le tour est joué.

Ne vous inquiétez pas, je vous explique à la fin de cette partie quelles informations renseigner dans ce fichier.

Pour l’instant, je vous propose de passer à la seconde méthode : vous allez faire travailler vos petites mains.

La méthode manuelle

Que vous utilisiez un plugin dédié ou pas, il est aussi possible d’ajouter un fichier robots.txt sur votre WordPress manuellement. C’est très simple, vous allez voir.

Premièrement, vous allez avoir besoin d’un éditeur de texte. Parmi eux, je peux vous recommander :

Sinon, votre bon vieux Bloc-notes fera aussi très bien l’affaire.

Créez un nouveau document, et sauvegardez-le sur votre ordinateur en le nommant robots.txt.

Son nom doit toujours être en minuscules, et n’oubliez pas de mettre un « s » au mot robots (n’écrivez pas

robot.txt).

Ensuite, connectez-vous à votre client FTP. Il s’agit d’un logiciel qui permet de communiquer avec votre serveur.

Personnellement, je me sers de Filezilla. Mais vous pouvez aussi vous tourner vers Cyberduck. Pour plus d’infos sur le mode d’utilisation d’un FTP, je vous redirige vers notre article dédié.

Un FTP vous sera aussi utile lors de l’installation d’un site WordPress. Pour en savoir plus, consultez notre guide : Comment installer WordPress comme un pro : le guide pas à pas.

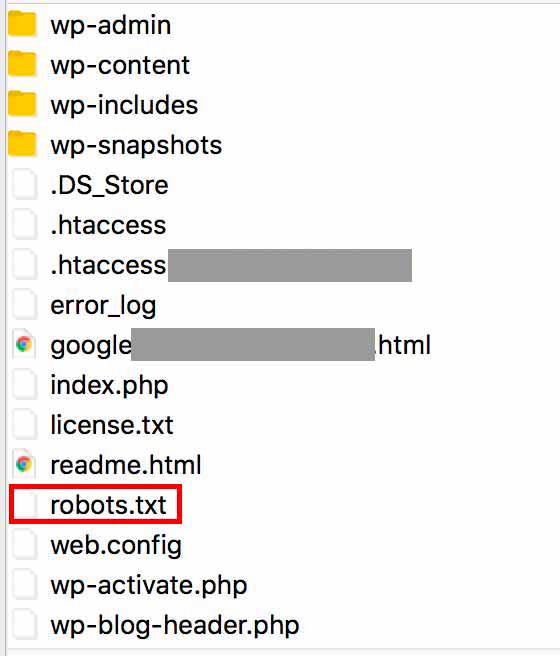

Troisième et dernière étape : ajoutez votre fichier à la racine de votre site. Je répète, à la racine de votre site, et pas dans un sous-répertoire. Sinon, les moteurs de recherche ne le prendront pas en compte.

Par exemple, si votre site est accessible via https://www.votresite.fr/, le fichier robots.txt devra se trouver à l’adresse https://www.votresite.fr/robots.txt.

Cet emplacement (la racine) peut varier d’un hébergeur à un autre. Chez o2switch (lien aff), il s’appelle

public_html. Chez OVH, vous le trouverez sous l’appellationwww.

Son implantation finale devrait ressembler à ça, chez vous :

Les règles essentielles à connaître

Félicitations, votre fichier robots.txt se trouve désormais sur votre serveur. Pour le moment, il est vide, mais vous pouvez l’éditer à votre guise quand vous le souhaitez.

Logiquement, vous devez vous demander quels types d’instructions mettre à l’intérieur.

Avant de se pencher sur ce point, il est nécessaire de bien saisir la syntaxe particulière de ce fichier.

Il est constitué d’un ensemble de règles qui « indique si un robot d’exploration donné est autorisé ou non à accéder à un fichier spécifique du site Web, précisé par son chemin d’accès », comme l’explique Google sur son aide sur la Search Console.

Les deux règles principales se nomment :

User-agent: désigne le nom d’un robot de moteur de recherche auquel la règle s’applique ;Disallow: désigne un répertoire ou une page, relatif au domaine racine, qui ne doit pas être exploré par leuser-agent. Rappelez-vous que, par défaut, un robot peut explorer une page ou un répertoire non-bloqué par une règleDisallow.

Je vous propose de décortiquer un exemple tout simple pour que vous compreniez bien.

Sur la première ligne, l’astérisque * est ce que l’on appelle une wild-card. Elle fait référence à tous les robots des moteurs de recherche (user-agent).

Sur la seconde ligne, on interdit (Disallow) l’accès à ces moteurs de recherche à tous les répertoires et pages de son site, via le slash /.

Vous n’avez pas besoin d’entrer votre nom de domaine (ex : monsite.fr/) avant le slash, car le fichier robots.txt utilise des URL relatives. Pour faire simple, il sait que le slash se réfère à la racine de votre nom de domaine.

Évidemment, le bout de code ci-dessus a peu d’intérêt si vous souhaitez que votre site soit exploré et indexé. Mais il peut-être utile lorsque vous êtes en phase de création de votre site.

Si vous ne souhaitez pas qu’un type de robot particulier explore votre site, par exemple celui de Yahoo (Slurp est le nom associé au robot de Yahoo), vous devrez procéder de la sorte :

Pour plus d’infos sur les noms des robots, je vous renvoie à cette capture issue du site Yoast SEO.

Quelques règles additionnelles

Je vous ai parlé de User-agent et de Disallow, qui sont les plus usitées. Sachez qu’il existe d’autres règles syntaxiques, mais elles ne sont pas prises en compte par tous les robots (par ceux de Google, oui). Parmi elles, on trouve :

Allow: permet l’exploration d’un sous-répertoire ou d’une page dans un répertoire non autorisé (Disallow) ;Sitemap: indique aux robots où se trouve votre sitemap. Cette ligne est facultative. Je vous recommande plutôt de soumettre votre sitemap aux moteurs de recherche via un outil dédié, comme la Google Search Console. Je vous explique comment faire dans cet article.

Pour être certain que vous compreniez bien, je vous propose d’aller un peu plus loin en vous proposant 3 nouveaux exemples.

Comment bloquer l’accès à un répertoire

Je demande à tous les robots de ne pas explorer la totalité des contenus du répertoire wp-admin.

Comment bloquer l’accès à une page ou à un fichier

Dans cet exemple, je demande à tous les robots de ne pas indexer la page de connexion à WordPress, ainsi qu’une photo.

Vous pouvez aussi voir l’apparition du symbole #. Il introduit un commentaire. Le texte situé derrière ne sera donc pas pris en compte.

Ayez aussi en tête que les règles sont sensibles à la casse.

Par exemple, Disallow: /maphoto.jpg correspond à http://www.monsite.fr/maphoto.jpg, mais pas à http://www.monsite.fr/Maphoto.jpg.

Comment créer différentes règles pour différents robots

Les règles sont toujours traitées de haut en bas. Rappelez-vous, elles commencent toujours par l’instruction User-agent, qui indique le robot auquel la règle s’applique.

Dans la première, je demande à tous les robots de ne pas indexer la page de connexion (wp-login.php).

Dans la seconde, je demande spécifiquement au robot d’exploration de Google (Googlebot), de ne pas explorer la totalité de mon site.

Comment autoriser l’accès à un fichier dans un répertoire bloqué

On se sert de l’instruction Allow. Dans cet exemple, tout le répertoire wp-admin est bloqué, sauf le fichier widgets.php.

Comment vérifier le bon fonctionnement de votre fichier robots.txt ?

Pour être sûr que votre fichier soit correctement paramétré, vous pouvez le vérifier et le valider sur la Google Search Console, un outil gratuit et incontournable pour gérer le référencement de votre site (entre autres).

Ouvrez l’outil de test du fichier robots.txt (vous devez y enregistrer votre site web au préalable).

Une fois que vous avez entré les instructions de votre choix dans l’éditeur prévu à cet effet, vous pouvez tester votre fichier.

Si tout va bien, vous devriez avoir le message suivant en bas de l’éditeur.

Sinon, c’est que votre fichier contient des erreurs de logique ou des avertissements relatifs à la syntaxe. Enfin, pensez à envoyer le fichier, en cliquant sur le bouton « Submit ».

Comment optimiser votre fichier robots.txt sur WordPress ?

Que faut-il mettre, ou ne pas mettre dans son fichier robots.txt ?

Existe-t-il un modèle prédéfini que l’on pourrait adapter sur chaque site ?

La réponse : à la fois oui et non.

En effet, chaque site est différent et il serait difficile de faire un copier-coller de ce que proposent Pierre, Paul ou Jacques sur leurs sites. Leurs problématiques seront très probablement différentes de celles que vous avez sur le vôtre.

Malgré tout, on peut vous donner un fichier robots.txt de base qui conviendra à la plupart des sites :

Pour tout vous dire, même au sein de la communauté WordPress, figurez-vous qu’il est impossible de mettre tout le monde d’accord. Les avis divergent.

Certains, comme Joost de Valk, le fondateur de Yoast, prônent le minimalisme. C’est d’ailleurs plutôt la tendance actuelle.

En substance, ils estiment notamment que comme Google est capable d’interpréter votre site dans sa globalité (notamment le code CSS et JavaScript, et plus seulement le HTML), il ne faut pas lui bloquer l’accès aux fichiers CSS et JavaScript pour qu’il puisse voir vos pages dans leur intégralité. Sinon, cela pourrait affecter votre SEO.

Pour vérifier que Google a bien accès à toutes les ressources nécessaires pour afficher votre page correctement, vous pouvez retourner sur la Google Search Console. Rendez-vous dans l’onglet « Inspection de l’URL », cliquez sur « Afficher la page testée », puis sur « Capture d’écran ».

Si votre site n’a pas son apparence habituelle (ex : certains styles ne sont pas appliqués), c’est probablement que certaines règles de votre fichier robots.txt sont à revoir.

Mais revenons-en à Yoast. Regardez leur fichier robots.txt :

Comme vous pouvez le remarquer, rien n’est bloqué !

D’autres préconisent une approche plus large et « sécuritaire » pour votre site. Ils conseillent, entre autres :

- d’empêcher l’accès à deux répertoires-clés de WordPress, comme le dossier

wp-admin(où se trouvent les éléments d’administration de votre site web) et le dossierwp-includes(qui abrite tous les fichiers de WordPress) ; - de désindexer la page de connexion (

wp-login.php) ; - ou encore de désindexer le fichier

readme.html, car il contient la version de WordPress que vous utilisez.

Bref, pas simple de s’y retrouver, au milieu de toutes ses recommandations !

En résumé, je vous conseille :

- de vous en tenir au strict minimum si vous n’êtes pas sûr de ce que vous faites. Sinon, les conséquences sur votre SEO pourraient s’avérer fâcheuses ;

- de vérifier que votre fichier n’ait pas d’erreurs sur la Search Console avant de le soumettre.

Conclusion

Comme vous avez pu le voir, le fichier robots.txt est un outil intéressant pour votre SEO. Il permet de signaler aux robots des moteurs de recherche ce qu’ils doivent explorer, et ne pas explorer.

Mais il doit être manipulé avec précaution. Une mauvaise configuration peut amener à une désindexation totale de votre site (ex : si vous utilisez Disallow: /). Alors, prudence !

Pour terminer cet article, je vous propose de faire un récapitulatif. Tout au long de ces lignes, je vous ai notamment détaillé :

- ce qu’était le fichier

robots.txt; - comment l’installer sur WordPress ;

- comment optimiser votre fichier

robots.txtsur WordPress pour le SEO.

Maintenant, à vous de jouer. Dites-moi si vous utilisez ce type de fichier et comment vous le configurez.

Partagez-moi vos remarques et retours d’expériences dans les commentaires.

Recevez gratuitement les prochains articles et accédez à des ressources exclusives. Plus de 20000 personnes l'ont fait, pourquoi pas vous ?

Hey salut,

Merci pour cet article. J’ai retenu qu’on pouvait laisser faire Yoast.

J’ai apprécié le lien vers l’article sur le crawl et l’impact SEO, étant donné que je cherche à générer plus de trafic vers mon blog.

J’attends avec impatience la semaine du référencement.

Bon article. Pour ma part personnelle j’ai choisi la configuration minimale pour mon robot.txt ã l’instar de ce que préconise Yahoo, sachant que pour l’aspect sécurisation du site je fais confiance à Julio Pottier

Merci ! très intéressant

Cet article tombait à pic!

Super article

très clairement expliqué même pour des débutants

bravo à toute l’équipe

Ah ben voilà ! Je vous avait interpellé sur twitter au sujet d’un article qui n’était pas encore écrit !! J’suis trop fort…

Merci en tout cas pour cet article que j’avais deviné donc 🙂

Bonjour,

On peut mettre le ligne pour sitemap dans robots.txt et aussi le mettre dans Google Search Console, ça ne créer pas de conflit, si ?

Le fichier robots.txt du site WP Marmite, a plus de ligne

https://wpmarmite.com/robots.txt

Il ne convient pas pour tous les sites (je ne prends pas en compte la ligne sitemap) ?

Merci

Bonjour, le sitemap dans le robots.txt ne sert à rien si tu le mets dans la search console (ce que je te conseille), et le nombre de ligne dépend vraiment du site en lui même après. Ne copie pas forcément celui de la Marmite pour ton site, utilises plutôt celui qu’on donne qui convient à tous les sites.

super intéressant. merci

Merci pour ce super article !

Encore une fois vous apportez de précieux conseils.

Bonjour et merci pour l’article ! Je me suis rendu compte que mes dossiers wp-includes et wp-content (je ne voudrais indexer que le dossiers upload) étaient indexés dans google.

Ma question est : étant donné que ces dossiers sont dejà indexés, modifier mon robot.txt va t-il les désindexer ou est-ce deja trop tard ?

Merci pour votre réponse 🙂

Bonjour, c’est normalement impossible. As-tu modifié quelque chose? En es-tu sur?

Bonjour,

comment faire si le fichier robots.txt ne veut pas se mettre à jour. Je l’ai bien renvoyer en FTP et demander une mise à jour à Google mais le fichier ne se met pas à jour et la date de passage des robots ne change pas (cela fait 1 mois).

Merci d’avance 😉

Bonjour, tu es sur d’avoir bien respecter toutes les étapes? Un mois me parait long quand même.

Salut Julien,

Yes, j’ai tout bien fait, je fais pareil sur plein d’autres sites web mais là, le robots c’est arrêté le 7 février et depuis rien y fait. Le robots.txt ne se met plus a jour.

Une solution ?

Franchement la comme ça je n’ai pas d’idée. Tu n’as pas d’autres erreurs dans ta search console?

Non, je n’ai rien, le site fonctionne très bien. J’ai déjà vu ça sur un autre site, c’était lié à un piratage mais là le site semble en bonne santé. Je ne trouve aucune solution sur le net.

Bonjour,

Merci pour cet article 🙂

Mais j’ai été bloqué bien vite lors du paramétrage de Yoast Seo 🙁

Vous proposez de cliquer sur l’éditeur de fichier, mais je ne l’ai pas Oo

J’ai une copie d’écran au besoin. Je n’ai que Import/Export et Lot…

Si vous avez une idée 🙂

Avec mes remerciements.

Jérôme

Bonjour, le plugin est à jour?

Bonjour,

J’ai le même problème, “Editeur de fichiers” ne s’affiche pas dans Yoast > Outils.

Savez-vous éventuellement comment procéder pour l’afficher ?

Merci beaucoup.

Bonjour Marion, cela signifie que c’est côté hébergement que l’édition de fichier n’est pas autorisé : https://wordpress.org/support/topic/no-file-editor/

Bonjour,

Je pense, il s’agit de la version 9.7. C’est Yoast SEO for everyone.

Il y a Réglages généraux, Réglages SEO, Search console, Reseaux sociaux, Outils, Premium, cours.

Ha, oui je ne suis en pas en premium.

Merci pour le soutien 🙂 Même psychologique 😉

Jérôme

Merci pour cet article bien clair, bien conçu.

Jérôme

Merci pour toutes les lumières que vous nous apportez dans ce monde de wordpress. Nous avons envie de grandir comme vous et bien gérer notre. je vous fais savoir que j’ai crée mon site de A à Z gràce aux tuto de la marmite…c’est très sympa de votre part. merci

Merci beaucoup ! On est ravi que le blog vous ai aidé à lancer votre site 🙂

Bonjour la Marmite,

J’ai tout fait comme indiqué et cela s’est bien passé.

Merci pour ces conseils.

f.

Article super utile 🙂

Merci wpmarmite

Bonjour,

Trop indiquer de restriction ou d’autorisation sans le fichier robots.txt n’aide-t-il pas les hackers où trouver les principales portes d’entrer d’un site ?

Amicalement.

Bonjour, non puisque les restrictions sont au final assez compréhensibles. Tu bloques les fichiers ou dossiers sensibles qui ne doivent pas être publics. Les hackers savent déjà lesquels viser 😉

Bonjour et merci pour cet article complet.

Concernant les multisites existe-t-il un plugin wordpress fonctionnel pour gérer ce fichier à la volée ?

Merci

Bonjour Cindy, en faisant une rapide recherche je n’ai rien trouvé en ce sens. Mais en utilisant un plugin de reférencement comme Yoast ou Rank Math tu peux le gérer. Sinon c’est “a la mano” comme on dit. Bonne journée

Merci beaucoup pour l’article M.Thibaut

C’est vraiment super détaillé et la compréhension est facile.

Merci !!!! Grace à vous j’ai enfin compris comment référencer mon site sur Google 🙂

J’ai passé plusieurs nuits blanche, en recherches, lectures et désespoirs.

Vos explications sont clairs et surtout vous avez pris le temps de mettre des exemples très utiles qui facilites la compréhension.

Il me reste maintenant à améliorer mon site, car il est basique et n’était destiné jusqu’à présent à avoir une simple présence sur Internet.

Alors merci encore, et portez vous bien !!

Super Serge 😉

Merci pour ces informations.

Cependant ne faut-il pas aussi ajouter le lien avec le sitemap également?

Bonjour, ce n’est pas obligatoire, et le mieux est de déclarer le sitemap dans ta Google Search Console.

Bonjour, merci beaucoup pour l’article. Par contre dans la search console je ne trouve pas comment faire et également dans yoast ( j’ai le premium), apparemment j’ai un souci de fichier txt.

Merci pour vos conseils.

Bonjour, tu n’as pas besoin d’eux pour créer ton fichier ?

Bonjour WP marmite,

un grand merci pour votre soutien et vox textes explicatifs avec screenshot et autres, tout comme les images d’humour qui permette à mon sens de mieux intégrer les cours / explications.

Une fois n’est pas coutume, un petit commentaire pour vous notifier que je viens de prendre connaissance de votre article, que j’ai crée tout le tintouin (et vous en remercie) et pour signaler que l’outil de “test du fichier robots.txt” n’est plus disponible à l’endroit indiqué (MAJ de article? :)).

Personnellement, j’utilise le plugin Rank Math au vu des articles plus récents que j’ai pu lire chez vous entre rank math et Yoast, aussi s’il y a une MAJ, l’intégrer serait-il un plus ?)

J’ai chercher sur l’aide et l’outil est disponible à cette adresse : https://www.google.com/webmasters/tools/robots-testing-tool?utm_source=support.google.com/webmasters/&utm_medium=referral&utm_campaign=%206062598.

Enfin , j’ai tester si certains robots étaient autorisés sur des dossiers sensible que je souhaiter exclure, et cela me met autorisé en vert.. Et en même temps, je viens seulement de créer le fichier donc les robots n’ont peu être pas eu l’info ? Bref, un peu perdu je suis. Je réessaierai dans quelques jours ^^

Belle journée !

Merci beaucoup pour ce lien, Benjamin !

Bravo pour cet article qui est très clair. Il y a quand même quelquechose qui me chiffonne. J’ai installé l’extension wordfence et quand je regarde le traffic d’accès à mon site, il y a beaucoup de sites (ou robots ?) qui lisent mon fichier robots.txt. Dans quel but certains sites lisent ils les fichiers robots.txt ? Est ce qu’il faut que je bloque leur adresse IP ?

Bonjour, ce sont généralement des robots et non des visiteurs. Tu peux les bloquer.

On peut ajouter l’instruction suivante pour préciser où se trouve le sitemap. Ça ne coûte pas grand chose et ça peut aider le robot à faire son travail.

Sitemap: https://example.com/sitemap.xml

Merci beaucoup, je cherchais des renseignements sur le robot-txt et j’ai toute les informations dans cet articles ! 🙂

Bonjour

Merci pour ce tuto sur le robots.txt. En tant que webmaster votre article m’a été utile car j’ai eu la demande d’un client de supprimer, ou plutôt de rendre en NOINDEX des urls ayant le slug /boutique/ après le nom de domaine car la suppression des urls via Google Search Console n’est que temporaire et il y en a beaucoup, un vrai casse-tête (merci le dev précédent d’avoir fait une migration Presta vers woocommerce pour changer les urls ensuite…

Je me suis donc appuyer sur votre exemple de fichier robots.txt

Nicolas

Bonjour Thibaut et merci pour tous tes super contenus. J’utilise Yoast SEO, mais je n’ai pas l’option Editeur de fichier là où tu la présentes, j’imagine que je ne suis pas la seule ? Comment faire pour l’obtenir afin de retoucher le fichier robots.txt ?

Merci !

Bonjour, effectivement cette option a été supprimé.